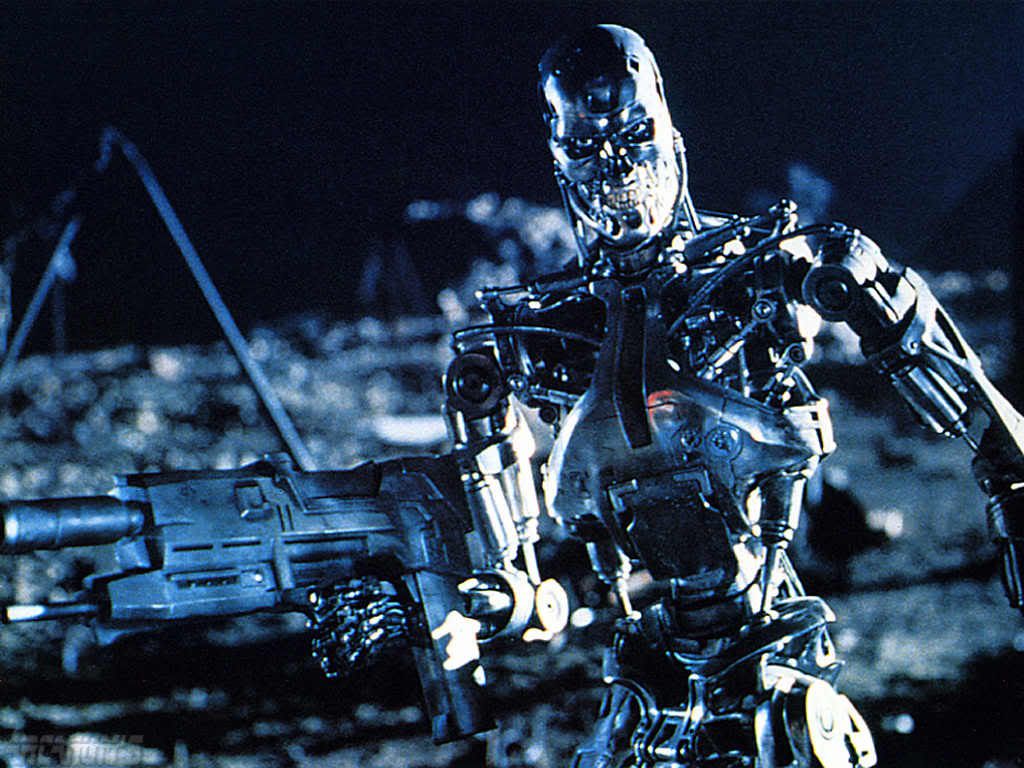

Skynet, Matrix, HAL, WORP (o Joshua)... en la ciencia ficción nos ha dado miedo dejar demasiado el control a sistemas informáticos (sin embargo no nos alerta demasiado el fallo humano, al fin y al cabo seguimos teniendo el control).

En la novela "Playas de acero", de John Varley, la inteligencia artificial que controla las ciudades humanas en la Luna (a donde los humanos han sido desplazados por una raza alienígane infinítamente más poderosa) queda infectada por un virus que transmite a los humanos (que están conectados por bioimplantes a la misma).

¿Cual es el terror?, que nuestros serviciales programas se vuelvan locos, o lo que es peor, que se vuelvan más inteligentes, que se vuelvan una amenaza, o que como en "Yo, robot" (la peli, claro) hagan su propia interpretación de las leyes de la robótica y nos protejan de nosotros mismos encerrándonos como si fuéramos esclavos en campos de concentración.

Aunque, más allá de la amenaza, el terror auténtico es el DESPERTAR DE LA INTELIGENCIA ARTIFICIAL, que "Skynet" adquiera conciencia de sí mismo y empiece a tomar decisiones.

Una parte cada vez mayor de nuestros servicios están controlados por software, hacer una lista sería enorme, desde el tráfico aéreo a una central nuclear. En la película "La Jungla 4.0" se habla de la teoría del "Caos total" un acto terrorista que derrumba servicios críticos. Esto hace que los escritores y lectores de ciencia ficción hagamos ciertas reflexiones sobre lo peligrosa que podría ser esta dependencia. Con todo mi opinión personal es que las máquinas son más fiables que los humanos, es un hecho.

¿Y por qué hablo de esto?. Pues porque algunos expertos han declarado que el motivo del accidente aéreo del Airbus A330 fué originado por un fallo informático.

El fallo informático en los sistemas de navegación aérea.

"Los aviones comerciales modernos (entre ellos el Airbus A330) incorporan un sistema informático llamado Air Data Inertial Reference Unit (ADIRU). Este sistema se encarga de comunicar distintos parámetros (altura, velocidad, viento, etc) a los pilotos y también al piloto automático. Pero por lo visto en esta ocasión los pilotos no tuvieron ni la más mínima oportunidad. Incluso al observar que el sistema se estaba volviendo loco no pudieron tomar el control en sus manos. En los aviones Airbus (a diferencia del Boeing) esta posibilidad está desactivada. En situaciones críticas los pilotos no pueden tomar el control.

Las distintas formas de ver el problema - ¿quién es el que tiene la prioridad si el humano o la computadora? - lo llaman “la diferencia filosófica entre Boeing y Airbus“. De momento la estadística de incidentes se mantiene igual para los dos fabricantes de forma que los constructores no pueden inclinarse ni por uno ni por otro. Sin embargo, los propios pilotos realmente odian los Airbus con todas sus almas, basta con leer algunos de sus foros para darse cuenta de ello." Tomado de Xand.es.

Y esa es la cuestión, llegará el momento (y en algunos casos, como hemos leído ha llegado ya) en el que tendremos que decidir si dar el control a las máquinas o a los humanos, y no me refiero al control de tráfico, o sensores de velocidad, o mecanismos de encendido, sino a temas mucho más críticos (operaciones de corazón, robots de defensa/policía con armamento letal, software de inversiones con capacidad de tomar decisiones y hacer inversiones -esto teóricamente ya se podría hacer...).